مطالعه جدید هوش مصنوعی نشان می دهد که chatbots در 50 ٪ از زمان خلاصه می شود – و این بدترین جنایتکار است

تحقیقات اخیر BBC ، Chatgpt Openai ، Copilot مایکروسافت ، دوقلوهای گوگل و حیرت AI ، از جمله چت های پیشرو AI ، اغلب در حالی که خلاصه اخبار را می داد ، اشتباهات قابل توجهی و حتی بدتر شدن ایجاد می کردند.

چکمه های چت کار ارزیابی و فاش کردند که بیش از نیمی از پاسخ های تولید شده حاوی نقص های بزرگی هستند.

دامنه کار بی بی سی برای ارائه 100 مقاله خبری به چهار چت بابات هوش مصنوعی از وب سایت و تهیه هر یک از آنها. متخصصان موضوع از بی بی سی سپس کیفیت این خلاصه ها را ارزیابی کردند. این یافته ها نشان داد که 51 ٪ از پاسخ های تولید شده توسط هوش مصنوعی اشتباهات قابل توجهی از جمله اشتباهات واقعی ، اسناد اشتباه و اطلاعات قدیمی را مرتکب شده اند.

اشتباهات خاص

در میان خطاها ، 19 ٪ از پاسخ های هوش مصنوعی که به محتوای BBC اشاره دارد ، خطاهای واقعی مانند تاریخ های کاذب ، اعداد و عبارات را به همراه آورد. علاوه بر این ، 13 ٪ از نقل قول های منتسب به BBC یا با فرم های اصلی آنها جایگزین شده اند یا در مقالات مشخص در دسترس نبودند.

این مطالعه تأکید کرد که پاسخ های جمینی به ویژه مشکل ساز است و 46 ٪ برای مشکلات دقت قابل توجهی مشخص شده اند.

نمودار بالا چند نمونه قابل توجه را نشان می دهد. دستورالعمل NHS جمینی تفسیر نادرست است. جمینی گفت که خدمات بهداشت ملی انگلیس (NHS) از Vaping به عنوان روشی برای ترک سیگار توصیه کرده است. در واقعیت ، NHS vaping را به عنوان یک کمک مناسب برای کسانی که سعی در ترک سیگار دارند ، توصیه می کند. این مطالعه تأکید کرد که پاسخ های جمینی به ویژه مشکل ساز است و 46 ٪ برای مشکلات دقت قابل توجهی مشخص شده اند.

از جمله مباحث دیگر ، اطلاعات سیاسی سابق هر دو Chatgpt و Copilot ، Rishi Altar و Nicola Sturgeon ، با وجود استعفای آنها ، هنوز به عنوان نخست وزیر انگلیس و وزیر اول اسکاتلند خدمت می کردند.

علاوه بر این ، غافلگیرانه دامنه خاورمیانه را گمراه کرد و ایران در ابتدا “محدودیت” را نشان داد و اقدامات اسرائیل را “تهاجمی” توصیف کرد.

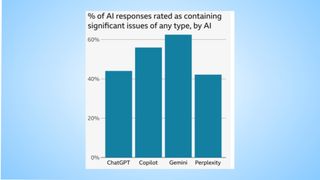

BBD همچنین بر درصد نگرانی های صحت و قابلیت اطمینان در کلیه مدلهای هوش مصنوعی آزمایش شده در هوش مصنوعی ، که حاوی مشکلات قابل توجهی است ، تأکید کرده است ، همانطور که در نمودار آبی بالا نشان داده شده است و به سؤالات مربوط به اخبار پاسخ می دهد. طبق مطالعه:

جمینی (گوگل) بیشترین درصد پاسخ های مشکل ساز ، بیش از 60 ٪.

Copilot (مایکروسافت) بیش از 50 ٪ پاسخ ها با مشکلات موجود از نزدیک مورد بررسی قرار گرفتند.

chatgpt (openai) وت تعجب این مشکلات نسبتاً کمتری را نشان داد که هر یک از آنها حدود 40 ٪ است.

این مطالعه حاکی از نیاز فوری به بهبود صحت ، شفافیت و مکانیسم های کنترل واقعی شرکت های هوش مصنوعی ، به ویژه در نمایش داده شدگان مربوط به اخبار است.

مداخله و نگرانی های بخش

Deborah Turness BBC News و مدیرعامل مدیر عامل شرکت مدیرعامل ابراز نگرانی خود را در مورد این یافته ها. در یک پست وبلاگ ، هوش مصنوعی تأکید کرد که کاربرد فعلی فناوری در جمع بندی اخبار در حالی که “فرصت های بی پایان” را ارائه می دهد ، پر از خطرات است. Turness مورد سؤال قرار گرفت ، “ما در زمان های مشکل ساز زندگی می کنیم و چه مدت عنوان به هوش مصنوعی تحمیل شده است برای دنیای واقعی مهم مضر بوده است؟”

Turness خواستار توسعه دهندگان هوش مصنوعی شد تا “عقب نشینی” را به “عقب نشینی” بردند و قول دادند که اپل خلاصه اخبار ایجاد شده توسط AI را پس از بی بی سی اظهار داشت. این مقام با بیان اینکه بی بی سی در تلاش است “گفتگوی جدیدی را با ارائه دهندگان فناوری هوش مصنوعی باز کند” برای یافتن یک راه حل جمعی ، یک رویکرد مشترک خواستار شد.

سخنگوی OpenAi به این مطالعه پاسخ داد و گفت: “ما با کمک به 300 میلیون کاربر چتپپ در هفته برای کشف محتوای با کیفیت از طریق خلاصه ، ناخن ها ، اتصالات خالص و انجمن ها ، از ناشران و سازندگان محتوا پشتیبانی می کنیم.” وی افزود: OpenAi برای افزایش دقت استناد و احترام به ترجیحات ناشران با شرکا همکاری کرده است.

استنتاج برای آینده

یافته های بی بی سی بر مشکلات ادغام هوش مصنوعی در پخش اخبار تأکید دارد. شیوع عدم دقت نه تنها باعث تضعیف اعتماد به نفس عمومی می شود ، بلکه خطرات احتمالی را نیز به وجود می آورد ، به ویژه هنگامی که اطلاعات نادرست مربوط به موضوعات حساس باشد.

پیت آرچر ، مدیر برنامه تولید هوش مصنوعی بی بی سی تأکید کرد که باید کنترل استفاده از ناشران را کنترل کند. وی از شفافیت در نحوه دستیاران خود از شرکتهای هوش مصنوعی اخبار و دامنه اشتباهاتی که تولید می کند ، حمایت کرد. آرچر گفت: “این امر به مشارکتهای جدی بین شرکتهای هوش مصنوعی و رسانه ای و روشهای جدید کار نیاز دارد که مخاطبان را در وهله اول قرار می دهد و ارزش همه را برای همه می کند.” گفت

با ادغام سریع هوش مصنوعی در صنایع مختلف ، این مطالعه بر لزوم نظارت دقیق ، همکاری و تعهد صحت تأکید می کند تا اطمینان حاصل شود که پیشرفت تکنولوژیکی بدون به خطر انداختن یکپارچگی دانش ، برای منافع عمومی خدمت می کند.